Forschungsprojekte

Statistik vor Gericht

In populärwissenschaftlichen Veröffentlichungen werden spektakuläre Fehlinterpretationen statistischer Befunde in Gerichtsurteilen angeprangert. Eine wissenschaftliche Untersuchung von Folgerungen für die Rechtsmethodik oder die juristische Ausbildung findet jedoch nicht statt. Häufig erscheinen die Beispiele wie z. B. der gut dokumentierte Fall der Sally Clark anekdotisch, obwohl die Auseinandersetzung mit statistischen Gutachten zur Tagesordnung an deutschen Gerichten gehört, und der Gebrauch statistischer Terminologie in den vergangenen Jahren stetig angewachsen ist. Sowohl das Spektrum der Rechtsgebiete als auch das Spektrum der statistischen Methodengebiete ist dabei breit gefächert, wie zwei Beispiele aus dem Strafrecht und dem Verwaltungsrecht anschaulich illustrieren.

Den Richterinnen und Richtern fällt hier - wie den Anwältinnen und Anwälten - die anspruchsvolle Aufgabe zu, statistische Sachverhalte adäquat zu würdigen und angemessen in die Urteilsfindung einfließen zu lassen.

Das Forschungsvorhaben untersucht die Frage, wie Juristinnen und Juristen beim Umgang mit statistischen Befunden sinnvoll unterstützt werden können. Im Vordergrund des Projektes stehen dabei statistisch–didaktische Fragestellungen:

- Welche Formen der quantitativen Methodenkompetenz sind für Juristen hilfreich?

- Wie lassen sich diese Kompetenzen gegebenenfalls in der juristischen Aus- und Weiterbildung vermitteln?

- Kann die Qualität der Rechtssprechung durch entsprechende Angebote verbessert werden?

Die Beantwortung dieser Fragen erfordert auch eine Auseinandersetzung mit grundlegenden juristischen Thematiken: Wie lässt sich die Argumentation anhand quantitativer Befunde transparent und konsistent in das Gebäude der Rechtsmethodik einordnen? Wie lässt sich das Heranziehen von Zufallsphänomenen und Stichprobenergebnissen mit dem Postulat der Einzelfallentscheidung vereinbaren?

Das Forschungsvorhaben ist ein gemeinsames Projekt der Universität Bremen und der Fachhochschule Kiel.

Betrugsprävention und -identifikation mit quantitativen Methoden

Manipulationen und Verstöße gegen Vorschriften bei der Erstellung von Rechnungswesendaten stellt ein schwerwiegendes Vergehen mit potenziell erheblichen ökonomischen und gesellschaftlichen Konsequenzen dar. Berichte über Steuerbetrug, -hinterziehung und –verkürzung sind regelmäßig in der Tagespresse zu finden und verursachen neben finanziellen Schäden in Milliardenhöhe für den Staat auch ein Gefühl sozialer Ungerechtigkeit in der Bevölkerung. Betrug in handels- oder börsenrechtlichen Finanzberichten führt zu Ineffizienzen an den Kapitalmärkten, da Investoren durch falsche Informationen getäuscht werden und ihr Kapital nicht mehr optimal allokieren können. Im Zuge zunehmend verflochtener internationaler Kapitalmärkte und des säkularen Trends einer Abkehr staatlicher (umlagefinanzierter) Rentensysteme hin zu einer deutlich stärkeren privaten (kapitalmarktorientierten) Altersvorsoge sind auch weitere gesellschaftliche Schäden zu beachten, ebenso wie die Gefährdung von Arbeitsplätzen durch Betrug des Unternehmens.

Das sporadische Auftreten von Betrugsfällen, komplexere Unternehmensstrukturen speziell in Verbindung mit dem Thema Digitalisierung und umfangreichere zu analysierende Datenmengen, erschweren die Identifikation von Betrugsfällen. Daher ist der Einsatz von statistischen Modellen und Verfahren eine unerlässliche Hilfe für Wirtschaftsprüfer, Finanzbehörden und andere Regulierungsinstitutionen zur Betrugsbekämpfung geworden.

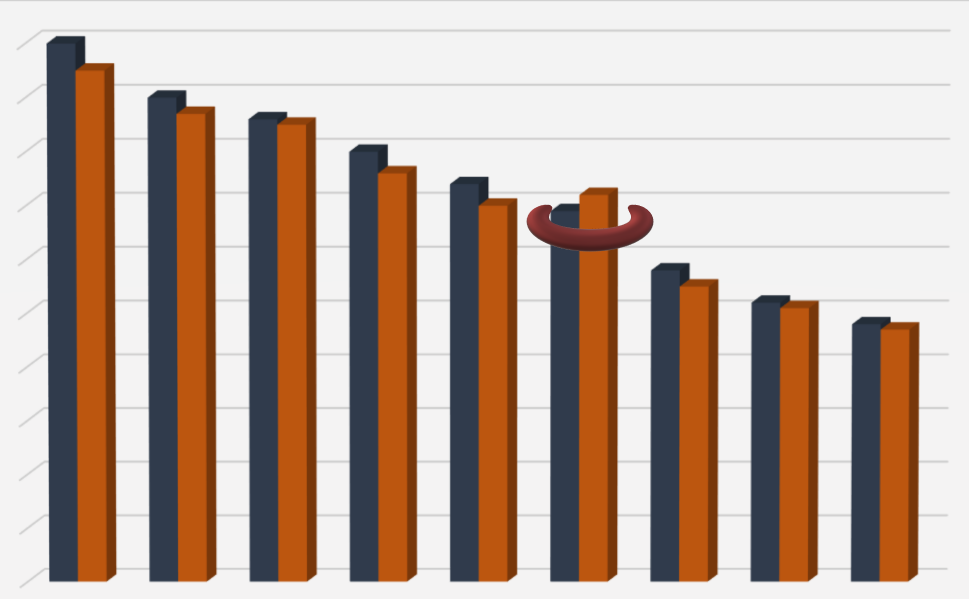

Im Forschungsprojekt wird die Eignung verschiedener statistischer Methoden zur Betrugsaufdeckung bei Steuer- und Bilanzbetrug evaluiert. Die angewendeten Methoden reichen dabei von Verteilungstests und Zeitreihenvergleichen über interaktive Prüfungsnetze, wie die Summarische Risikoprüfung, bis zu Methoden des unüberwachten und überwachten maschinellen Lernens (insbesondere Bayessche Netze und Neuronale Netze) zur Klassifikation. Gleichzeitig wird die rechtliche Zulässigkeit dieser Methoden als Ausgangspunkt für Untersuchungen und als Beweismittel vor Gericht untersucht und juristische Konsequenzen für die Gesetzgebung diskutiert.

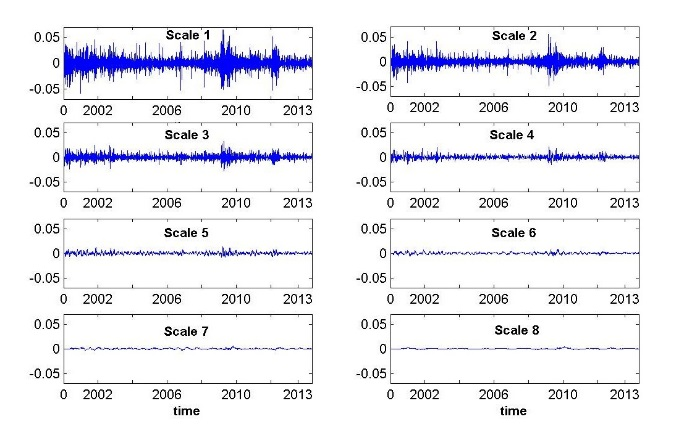

Wavelet-Analyse im Risikomanagement

Wir zerlegen Renditezeitreihen aus dem Finanzbereich in verschiedene Zeitskalen, um kurzfristige Störungen von langfristigen Trends zu unterscheiden. Außerdem untersuchen wir Abhängigkeiten zwischen Aktien, in verschiedenen Zeitskalen, vor und nach dem Ausbruch der Finanzkrise. Die Verwendung von zerlegten Renditezeitreihen ist in dieser Form im Portfoliomanagment neuartig. Wir modellieren Portfolios so, dass die Volatilität jeder Zeitskala minimiert wird.